The original article was published on Glass Bead, 2017

Quale relazione può emergere tra la progettazione urbanistica e lo sviluppo delle tecnologie percettive che le macchine utilizzano per orientarsi e operare? Ben oltre l’idea di Smart City, il problema dell’intelligenza trascende la dimensione umana: nel progettare città percepite e percepenti, diventiamo reciprocamente gli abiti l’uno dell’altro: mentre la città ci veste, noi vestiamo la città.

_____________________________________

I designer tracciano i loro segni sui fili dell’ordito di ciò che potrebbe sembrare un’immensa veste senziente – quella che vivrà sulle e nelle superfici delle nostre future rovine. Un abito che combina diversi tipi di intelligenza artificiale, sensori industriali incorporati, dati estremamente rumorosi, decine di milioni di macchine di metallo e cemento in movimento o a riposo, miliardi di computer palmari a lastre di vetro, altri miliardi di ominidi senzienti, e un groviglio di modelli di astrazione degli input raccolti da tutto ciò. In un orizzonte così disomogeneo emerge l’amalgama di un’orchestra di automazione, capace di creatività e crudeltà inaspettate: una caverna alla rovescia che potremmo chiamare, legandoci all’oceano di Solaris di Stanisław Lem, la città plasmatica. (Ben diversa dalla “città intelligente”. Questa impiega strumenti simili, ma è attraversata dal sogno dell’onniscienza municipale e l’ottimizzazione dei servizi. All’interno di questo nuovo abito i programmi urbani moderni, che sono stati definiti dai cicli di residenza, lavoro,e intrattenimento delle epoche precedenti, vengono riordinati, ma per la Smart City sono reificati e rafforzati, riconosciuti erroneamente come costanti quando sono in realtà variabili).

Consideriamo per un istante l’indossabilità di questo indumento, come fosse una sorta di pelle. Dato che molti apparecchi di rilevamento, su scala urbana, estendono o allegorizzano la vista, può parer singolare concentrarsi proprio sulla pelle. Essa è però il nostro organo sensoriale più esteso. Abbiamo sì ampliato vista e udito artificialmente, ma le tecnologie moderne hanno invece fatto molto meno per ottimizzare la sensibilità epidermica (nonostante, ultimamente, gli sforzi sembrino andare in tale direzione)1. Le tecnologie della pelle fanno parte di ciò che gli esseri umani effettivamente sono: invece di evolvere nuove pelli a ogni nostra migrazione, abbiamo affinato le tecniche di creazione di rivestimenti temporanei a scopi speciali, adatti al caldo, al freddo, all’immersione, ai drammi rituali, alla mimetizzazione o alla segnalazione di ruoli. La presentazione di sé e le dinamiche di selezione sessuale che ne derivano si basano in larga parte sulla semiotica locale di come interpretiamo queste pelli artificiali; a svilupparsi è stata perciò un’industria globale della moda e del merchandising tessile. A livello più funzionale, le pelli sintetiche modulano i nostri ambienti, sintonizzandoli verso il “mite” [come indice climatico, ndt]2. Noi non siamo, però, gli unici a comportarci in questo modo. Una sensibilità urbana permetterebbe alle superfici della città di percepire il loro ambiente (di rispondere alle domande: chi, cosa, dove, quando, come?). A sua volta, l’Intelligenza Artificiale su scala urbana non dipenderebbe tanto dall’AI intesa come elemento da ridurre su una piastra di Petri, quanto piuttosto dall’AI libera nell’ambiente, che sente, reagisce e indicizza il suo mondo3. Quando una connotazione diversa e più letterale di “cognizione distribuita” prende forma in questo modo, la linea già contestata tra sensibilità del mondo ed elaborazione delle informazioni subito si offusca.

Definire cosa sia una protesi, e di quale corpo essa sia tale, è un’impresa aperta a più prospettive rispetto a quella che prende in esame le catene di comando con controllo accentrato4. Poiché vestiamo pelli sui nostri corpi allo stesso modo che sui nostri edifici, sotto una pelle atmosferica composta da onde di schiuma (come direbbe Sloterdijk), questa disposizione naturalizzata viene disturbata dal modo in cui la sensibilità urbana sembra avvicinarsi alla proto-senzienza. Una persona non è solo un agente vitruviano in qualche nucleo fenomenologico che indossa la città: quella stessa persona viene indossata a sua volta. Siamo, allo stesso tempo, la pelle di ciò che indossiamo. L’indumento che viene tagliato e cucito per noi non è l’unica forma di vestiario. La città ci indossa allo stesso modo in cui noi indossiamo lei.

I sensori della città e la sensibilità

Dacché l’intenzione è descrittiva e non prescrittiva, prima di considerare qualsiasi forma di percezione e sensazione futura possibile risulta necessario mappare le nostre attuali modalità percettive. Quella che definiamo semplicemente intelligenza artificiale non si basa su un accumulo di input grezzi, ma su impressioni modellate a partire dai dati di quegli input. Qualsiasi intelligenza funzionale è definita dalla sua capacità di agire sul suo mondo, e tale capacità è intesa a partire da cosa e da come può percepire quel mondo, e se stessa al suo interno. In gioco c’è una teoria degli affetti specifica per le macchine, che forse sarà necessario sviluppare negli anni a venire.

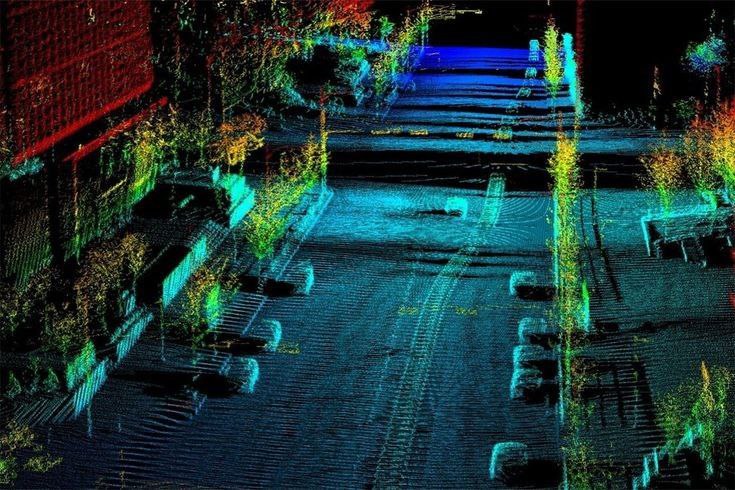

Prendiamo ad esempio le auto senza conducente, in quanto emblema delle grandi e massicce macchine che percepiscono e apprendono mentre calcano le strade. I loro sensori propriocettivi includono rilevatori di velocità delle ruote, altimetri, giroscopi, tachimetri, sensori tattili, mentre i loro rilevatori esterocettivi includono telecamere visive multiple, LiDAR per la ricerca del raggio d’azione, radar a breve e lungo raggio, sensori a ultrasuoni sulle ruote, sistemi satellitari di posizionamento globale o antenne di geolocalizzazione, e via dicendo. Tra rilevamento e interpretazione, diversi sistemi si sovrappongono: gli algoritmi che scannerizzano i segnali stradali e le loro caratteristiche, le mappe delle strade che la macchina si appresta ad attraversare durante il tragitto, e gli algoritmi di comportamento dell’interazione tra auto. Nel ventaglio fra completamente autonomo e parzialmente autonomo, gli esseri umani all’interno dell’abitacolo forniscono un’altra componente intelligente che può essere variabilmente copilota o carico. Sistemi di guida ed essere umano, insieme, formano un Utente composito che si muove attraverso lo strato cittadino di The Stack5.

I sistemi di rilevamento e di pensiero, a ogni modo, non si trovano solo nei soggetti e negli oggetti di valore che gironzolano per le strade: essi sono integrati nel tessuto della città in vari mosaici. Poiché il modo in cui una città senziente pensa è inestricabile dal modo in cui percepisce, un buon catalogo non è tanto una litania di oggetti in un’ontologia piatta o l’insieme di funzioni in un nuovo modello di tecnologia. Piuttosto, si tratta di un indice anatomico delle capacità e delle limitazioni interconnesse di un incipiente mondo sensoriale macchinico. Il corpo distribuito comprende non solo sensori automobilistici, ma anche sensori di componenti digitali, rilevatori di flusso e di umidità, di posizione, di velocità e inerziali, misuratori di temperatura, di movimento relativo, sensori di luce visibile e “telecamere” di registrazione, di posizione, scanner locali e di vasta area, rilevatori di vibrazione, di forza, sensori di coppia, sensori di bagnato, sensori a pellicola piezoelettrica, rilevatori di proprietà dei fluidi, a ultrasuoni, di pressione, di livello dei liquidi e così via. Ampliando il punto di vista, i sistemi di telerilevamento in orbita terrestre bassa si intrecciano con le reti terrestri per attingere dati a turno dall’alto e dal basso. Il geosensing remoto può osservare corpi idrici, vegetazione, insediamenti umani, suoli, minerali e geomorfologia con tecniche che includono la fotogrammetria, i sistemi multispettrali, le radiazioni elettromagnetiche, la fotografia aerea, i sistemi multispettrali, il rilevamento a infrarossi termici, il rilevamento a microonde attivo e passivo e il LiDAR a diverse scale6. Sebbene molti di questi sistemi facciano parte delle città, delle fabbriche e delle geografie da decenni, la loro integrazione nel paesaggio attraverso protocolli e reti computazionali standardizzati (secondo i modelli convenzionali dell’Internet delle Cose o simili) significa che l’intelligenza artificiale specifica di tale dominio, e l’AI più in generale, si è ritagliata un percorso al di fuori dei laboratori e verso la robotica evolutiva su scala metropolitana. Chiediamoci allora: come devono essere indossati questi sistemi?

Vestibilità

L’informatica indossabile, come settore dell’elettronica di consumo, è a livello a dir poco embrionale. Oggi il termine si riferisce principalmente a orologi intelligenti e sensori che monitorano il battito cardiaco o il livello di glucosio nel sudore, o a luci lampeggianti sui vestiti attivate da un software di sequenziamento. Non parliamo, per ora, di cose molto stimolanti. Col tempo, tuttavia, man mano che la microelettronica e gli strati di elaborazione del segnale andranno a ridursi e diventeranno più efficienti dal punto di vista energetico, il settore allargato dei wearable potrebbe farsi predominante, proprio come l’informatica mobile ha preso il posto dell’informatica desktop. Più interessante è il modo in cui la miniaturizzazione e l’appiattimento dei profili di sistema possono consentire di coprire molti tipi diversi di pelli: pelli animali e vegetali, pelli architettoniche, pelli macchiniche… Qualsiasi superficie è potenzialmente una pelle, e la sua sensibilità è aperta alla progettazione. I gruppi di sensori che equipaggiano le auto dei conducenti, ad esempio, si evolveranno, si combineranno e si specializzeranno ulteriormente. I discendenti di queste matrici potrebbero coprire altre macchine, in movimento o a riposo, familiari o sconosciute. L’indossabilità, quindi, non è solo per gli utenti umani, e nemmeno solo per i corpi in movimento, ma per qualsiasi “utente” che abbia una superficie.

Così come ciò che conta come pelle cambia una volta che le capacità sensoriali di una superficie sono rese più animate, ciò che conta come “indossabilità” cambia quando pelli differenti sono ottimizzate da sensori condivisi. In altre parole, la flessibilità e l’ubiquità di questi sensori è anche una funzione della piattaformizzazione di componenti e sottocomponenti tra le varie applicazioni, e la distribuzione di sensori uguali o simili su superfici diverse implica che tipi di corpi molto differenti condividono gli stessi sistemi percettivi. Una versione di un sensore incollata sulla pelle di un mammifero può derivare genealogicamente da un sensore presente in una catena di montaggio e, se prendiamo sul serio le implicazioni dell’evoluzione tecnica, questa mescolanza di sensori su diverse superfici dermiche è alla base della costruzione di cyborg tanto quanto lo è l’inter-assemblaggio degli organi.

Gli usi raccomandati oggi per i wearable si basano su banali indicatori di performance e sull’ottimizzazione di funzioni che possono derivare da contesti sociali in declino. Il potenziale della computazione indossabile ampiamente considerato non può ridursi a questo auto-managerialismo, ma piuttosto riferirsi al fiorire di biosemiosi imprevedibili tra utenti capaci di percepire ed essere percepiti gli uni dagli altri in modi inusuali. Parliamo di esperienze singole, frammenti isolati e non pensati, oppure anche di coagulazioni di processi più profondi attorno ai quali si struttura la nostra decisione di chi essere.

Nel frattempo, la comprensione convenzionale della nostra pelle guiderà e limiterà ciò che l’ambito ampliato delle pelli sintetiche e dell’informatica indossabile è chiamato a fare. Prima o poi, però, potremmo imbatterci in fenomeni per i quali non abbiamo parole sufficienti (così come abbiamo un linguaggio incompleto per il dolore: il glossario del tatto è muto) e la pelle in cui viviamo ora sarà resa nuova da nuovi termini.

Pelli naturali, pelli artificiali

L’abbigliamento è già di per sé una pelle sintetica, e le sue funzioni non riguardano solo la regolazione termica o la protezione dalle abrasioni, ma anche la trasmissione ad altre persone di significative informazioni subculturali relative a chi siamo, e non solo a cosa siamo. Non è che i vestiti rossi significhino una cosa e quelli blu un’altra; attraverso la sua semantica incredibilmente sfumata, la moda produce fenotipi temporanei che si segnalano l’un l’altro all’interno delle torsioni e delle svolte dei riferimenti ipercontestuali: la formalità stagionale dell’orlo, la dimensione di un colletto, la noia di un verde, l’ottusità di un marchio o del nome di una band su una maglietta, il rapporto volumetrico delle sfere che compongono una collana che può o meno collegarsi a una piega triangolare che espone solo una parte della spalla. Le dinamiche sociali non sono solo rappresentate o eseguite da questa semiotica plastica, ma sono direttamente e immanentemente calcolate da essa7.

Non siamo neanche per caso l’unico animale a fare questo tipo di cose, e percorsi diversi si disegnano in altre forme di cognizione distribuita8. Mentre noi abbiamo sviluppato pelli sintetiche, altri animali hanno sviluppato pelli naturali più complesse, capaci di incredibili gesti pregni di significato. Le seppie, per esempio, usano i cromatofori nella loro pelle per abbagliare le prede, nascondersi dai predatori e comunicare con le altre seppie. La stessa reazione può avere scopi diversi a seconda del contesto di presentazione. (Mentre i corvi sembrano avere una teoria pratica della mente, non presumiamo che le seppie siano in grado di immaginare come la loro pelle appaia a un altro organismo, e quindi chiamare il loro luccichio “performance” è probabilmente impreciso. In questo caso, allora, che cosa si può dire vedano l’una dell’altra?). L’intelligenza è nella pelle stessa: è questa la consapevolezza cruciale. I cromatofori e gli iridofori delle seppie si modulano istantaneamente per produrre schemi complessi e abbaglianti che corrispondono a schemi neuronali isomorfi. Poiché pelle e cervello sono legati da circuiti diretti, possiamo dire che le incredibili animazioni della membrana sono una reazione nervosa e cognitiva. La lezione delle seppie su come immaginare una ricca ecologia di AI su scala urbana è cruciale. Non si tratta del cervello centrale e distaccato in Alphaville di Godard, ma di qualcosa di molto più distribuito e meno cartesiano. L’intelligenza è nella pelle e il regime sensoriale urbano, per conto del quale progettiamo, potrebbe essere qualcosa di simile a una topografia di una post-seppia tratta da un progetto di Lucy McRae9. Ma al di là della provocazione iperstizionale, che dire dei dettagli dell’ingegneria del rilevamento e della sensazione? A quale scala inizia?

Tutto è chimica

L’economia è economia ecologica. Dovrebbe essere ovvio che il design non galleggia come uno strato virtuale sopra una natura data. Alcune filosofie del design lo hanno capito molto tempo fa, e la storia delle biotecnologie post-Asilomar è adornata da concetti, narrazioni e modelli diegetici di biodesign congetturale, che informano i dibattiti con cui si considerano le implicazioni etiche, ecologiche e politiche di queste tecnologie10. Le biotecnologie sono controverse lungo regolari linee di faglia politica, e tuttavia, al di là di queste, le preoccupazioni sono talvolta possedute da postumi di creazionismo. Con questo termine non si vuole intendere (necessariamente) la convinzione che tutto il mondo sia stato creato da un agente monoteista. Si tratta piuttosto di un senso più diffuso secondo cui l’ordine del mondo non è solo un sistema dinamico adattivo, ma un testo speciale in cui ci appaiono istanziazioni di essenze metafisiche. Ne consegue che una tale postura implichi che quest’ordine sia servito al meglio evitando di contaminarne le forme (il tabù sull’agricoltura scientifica teologicamente ispirato, ad esempio, da Vandana Shiva) o negando che le perturbazioni fondamentali del sistema siano davvero possibili (la negazione teologicamente ispirata del cambiamento climatico antropogenico evangelizzata, ad esempio, dal senatore James Inhofe)11. Queste posizioni sono spesso accompagnate da ammonizioni contro l’arroganza e la tracotanza dell’umanità, ma ci sono decisamente modi diversi di intendere la questione. La posta in gioco per il biodesign non ha tanto a che fare con il controllo (reale o immaginario) sulla natura, o sul ponderare se ciò sia un bene o un male; piuttosto, la questione è posta a livello della demistificazione del corpo umano reale che torna a essere materia, e della localizzazione del soggetto progettante come una forma di materia che agisce sulla stessa materia che abita. In questa modalità, il fondamento limitante del design è la chimica.

Perché la chimica? e in che modo lo è? Consideriamo il progetto Nanome che abbiamo contribuito a sviluppare al D:GP dell’Università della California, a San Diego. Si tratta di un insieme di strumenti di modellazione e progettazione scientifica basati sulla VR, tra cui CalcFlow e NanoOne12. In breve, si usa la matematica virtuale per fare fisica virtuale, che si usa a sua volta per fare chimica virtuale, che si usa, ancora, per fare biologia virtuale. Le applicazioni per le biotecnologie e la sintetizzazione di farmaci sono prime applicazioni di prova, ma fornire modi più semplici per visualizzare la matematica come elemento costitutivo della modellazione molecolare ha implicazioni decisamente più fondamentali 13. Come con molti altri software di progettazione complessi, vediamo l’integrazione di sistemi di apprendimento automatico per aumentare ed estendere i gesti di ricerca delle forme, e in questo caso vediamo l’accumulo di domande e soluzioni di progettazione utilizzate anche come dati di addestramento per le AI di ricerca biotecnologica14. In altre parole, il livello di interfaccia per l’utente umano (un mezzo per mappare, modellare e simulare i processi materiali) è il livello di input per l’AI (un modello di richieste, sia induttive che deduttive, che strutturano lo spazio di ricerca per il sistema di apprendimento automatico). In questo senso, la biologia sintetica può essere vista come un genere di intelligenza artificiale applicata. L’insieme di questi elementi può supportare importanti scoperte (un giorno, forse: fotosintesi sintetica su scala industriale e terapie farmacologiche personalizzate su richiesta) e rendere il “materialismo culinario” della biochimica più accessibile alle iniziative popolari di design/hacker (sperando che ciò sia una buona cosa)15. In effetti, il primo potrebbe rivelarsi possibile solo grazie al secondo.

Pensiamo di saperne abbastanza dell’intelligenza animale e vegetale, ma l’intelligenza artificiale su scala urbana è per lo più un’intelligenza minerale. I metalli, la silice, la plastica e l’informazione scolpita in essi dall’elettromagnetismo costituiscono la base materiale (ma non del tutto, come vedremo più avanti). A sua volta, l’intelligenza artificiale è un genere di chimica inorganica applicata. Sottolineando gli input sensoriali che localizzano qualsiasi intelligenza artificiale nel proprio tipo di mondo, vediamo che questa base minerale non la ritira in un vuoto arido dalla carne umida, calda e termodinamica del mondo, al contrario. Se, come ipotizzò il cosmista russo Nikolai Fyodorov più di un secolo fa, noi siamo la materia piegata in modo tale da far pensare la Terra a se stessa, allora tali pieghe sono disponibili anche per diversi tipi di materia, compresa la miscela di composti organici e inorganici che compongono i sistemi di rilevamento/pensiero delle IA su scala urbana.

La persistenza dei modelli

Nel tentativo di individuare dove l’intelligenza artificiale può o non può essere collocata in questo ripiegamento, la definizione delle relazioni pratiche tra rilevamento e pensiero va in primo piano. Ritornano i fili conduttori dei dibattiti tra Hume e Kant: come (e infine se) il sensoriale dell’osservazione empirica si relazioni con una cornice “trascendentale” che dà coerenza morale e una più ampia deduzione al giudizio riflessivo di ciò che è percepito e, infine, all’interiorità fenomenologica. Ai fini dell’urbanistica dell’intelligenza artificiale, possiamo invocare questa divisione fondamentale della filosofia europea moderna in via provvisoria e forse solo analogica, ma la questione che ci poniamo è: a che punto il progetto di chimica inorganica della sensazione ingegnerizzata deve possedere qualcosa di simile a una “cornice”? O anche, potrebbe definirsi o evolversi in modo tale da possedere una cornice? E se così fosse, come cambierebbe il modo in cui noi disegniamo tali cornici?

Accanto alle cartografie di Reza Negarestani relative alle modalità epistemiche induttive e deduttive, possiamo qualificare le diverse specie-genere di intelligenza artificiale in base alla loro relativa dipendenza da una delle due estremità di questo spettro: ricca di input e povera di modelli (induttiva), povera di input e ricca di modelli (deduttiva). In linea di massima, possiamo dire che le IA “vecchio stile”, basate sulla logica simbolica, si affidavano a mezzi più deduttivi, attraverso la costruzione formale di modelli di un determinato spazio problematico, basati sulla comprensione delle scale locali e intermedie di causa ed effetto all’interno di quello spazio. In linea di principio, se un’intelligenza artificiale dovesse incontrare una versione reale di quello spazio problematico, dovrebbe dedurre cosa fare in seguito applicando la logica generica all’istanziazione specifica. Per molte ragioni ben note – dall’insufficienza dei dati e delle risorse di elaborazione, alle limitazioni adattive della simbolizzazione logica – questi metodi sono caduti in disuso rispetto ad approcci più induttivi. Ad esempio, i sistemi di deep learning basati su reti neurali artificiali costruiscono risposte funzionali agli insiemi di input, limitando i vettori in output riconoscibili. Per tali sistemi, la risposta funzionale agli input può essere ottenuta senza che il sistema produca nulla di simile a un “modello” formale riconoscibile dello spazio del problema.

Tuttavia, non possiamo cercare tali cornici solo nei sistemi di AI astratti dall’implementazione nel mondo reale. Seppure l’opacità dei processi di deep learning suggerisce forme interessanti e aliene di “pensiero”, in quanto apparati pratici di infrastrutture urbane i nostri sistemi di IA non sono privi di pregiudizi cognitivi umani, siano essi espliciti o impliciti, positivi o negativi. In base a una diversa connotazione del termine, in una rete neurale artificiale sono necessari pesi e bias per trovare prove di un particolare modello. Ma l’organizzazione dei dati in ingresso in un corpus utile è essa stessa informata da molti modelli differenti, compresi quelli culturali, che sono necessariamente pieni di errori e patologie di carattere apofenico. Secondo una visione di questo sistema, il modello (culturale) che strutturerebbe i dati di input è esterno al sistema di apprendimento profondo, ma da un altro punto di vista l’intero apparato e il suo funzionamento devono essere considerati a livello più elementare come interconnessi e co-costitutivi, ma più probabilmente come parte di un composto dinamico che mescola la semiotica ominide con la cognizione macchinica (i filtri either/or del Test di Turing non funzionano nemmeno qui). Le piccole e grandi infrastrutture che attraversano la città plasmatica sono sempre un assemblaggio cognitivo cibernetico: esse attingono a modelli del mondo che sono codificati in una sequenza mentre vengono sottratti da un’altra. I modelli sono mobili, sfuggenti, di solito non responsabili nemmeno di se stessi. In altre parole, seppure la bellezza del deep learning stia nel fatto che i suoi processi iperinduttivi producono risultati che spesso non corrispondono (o non possono corrispondere) ai modelli di come pensiamo di pensare, la composizione “esterna” dei dati di input rilevanti per l’output desiderato è già interiorizzata nelle sue operazioni. Come ci si aspetterebbe, e come è stato dimostrato, i pregiudizi espliciti e impliciti nei dati di formazione (“Che cos’è il rischio? che faccia ha?”) non solo si riflettono negli output, ma vengono sintetizzati e amplificati, e spesso sono protetti da una falsa obiettività 16.

Sul campo

Se, alla fine, questo indumento copra rovine urbane o una nuova razionalità della natura selvaggia è una questione di composizione, non di previsione. Anche se l’urbanistica dell’intelligenza artificiale fosse un riflesso, essa sarebbe anche un allontanamento, e sarebbe un grave errore evitare quest’ultimo a causa del primo. O, più precisamente, non sarebbe saggio osservarci solo nella riflessione. Possiamo descrivere l’ubiquitous computing non solo perchè ha introdotto supporti informativi sulle superfici, ma anche per il modo in cui esso attinge dalle, e manipola le, informazioni già presenti. In teoria e in pratica, la sua ubiquità può estendersi nel profondo del substrato materiale delle cose e attraverso distanze irregolari. Molto prima dell’informatica moderna, o prima della comparsa di creature simili all’uomo, l’evoluzione si è allontanata dall’entropia primordiale e si è orientata verso l’eterogeneità biochimica e la diversità nidificata. L'”informazione” è stata intesa come il calcolo di questo ordinamento del mondo, come si vede nei modelli di codifica e trasmissione genetica, nelle morfologie degli organismi, nelle contaminazioni trasversali e nelle simbiosi, nella selezione sessuale intraspecie, nelle dinamiche di nicchia interspecie, nelle esibizioni e nei camuffamenti e in vari tipi di segnalazione attraverso confini mutevoli17. L’informazione, in questo senso, può essere non tanto il messaggio in sé quanto la misura dello spazio di possibilità con cui la mediazione è possibile in un determinato contesto.

Ora, mentre volgiamo lo sguardo nel baratro di una sesta grande estinzione, l’informazione è anche una misura di quella diversità che sta crollando. I folli cicli di estrazione degli idrocarburi, la loro fabbricazione istantanea in forme fugacemente ordinate (una plastica di questo o di quello) e il loro trasferimento in flussi di rifiuti che non possono essere riassorbiti metabolicamente in maniera abbastanza veloce sono, tra le molte altre cose, una figura (e una sfigurazione) informativa18. Detto questo, qualsiasi etica volta alla massima diversità informativa che ci auguriamo possa sostenere le economie ecologiche sarebbe qualificata dal ruolo funzionale della standardizzazione che consente alla significazione codificata di diventare comunicazione. Si consideri, ad esempio, come il riciclo degli atomi di carbonio faccia sì che la vita organica decada e riviva in forme diverse, o come le firme comuni degli enzimi secreti facciano sì che la comunicazione stigmergica all’interno di una colonia di formiche ne sostenga l’organizzazione, o come una gamma condivisa di visione all’interno dello spettro luminoso renda possibile la mimetizzazione, o come i riferimenti semiotici comuni tra mittente e destinatario mettano in moto qualsiasi economia simbolica culturalmente complessa, e così via. Il design deve prevedere l’introduzione deliberata di canali di traduzione e integrazione, nonché di confini normativi che rafforzino le differenze esistenti o ne provochino di nuove. In altre parole, la filosofia del design informata da un’etica dell’informazione ecologica non può elevare la deterritorializzazione al di sopra della territorializzazione, o viceversa.

È con questa seria avvertenza che ci proponiamo di inserire gli ambienti ottimizzati nei programmi di urbanistica dell’AI. I processi descritti dalla biosemiotica formale – relazioni tra parassiti e ospiti, piante in fiore e insetti, predatori e prede, eccetera – non sono solo cose che l’AI può conoscere, ma possono anche essere direttamente equipaggiate con tecnologie di rilevamento sintetico e di ragionamento algoritmico. La presunzione che, tra tutte le entità ricche di informazioni del mondo, il cervello degli ominidi debba essere la sede primaria, se non esclusiva, da cui si estenderebbero le protesi di IA, si basa su molteplici errori di riconoscimento di cosa e dove sia l’intelligenza. In tale circostanza, l’intelligenza non solo si irradia da noi nel mondo, ma è già nel mondo, e sotto forma di informazione (che è forma) è il mondo.

I sistemi di monitoraggio e rilevamento ambientale possono descrivere e prevedere lo stato dei sistemi viventi nel tempo, ma di solito non possono agire su di essi. Sono ricchi di sensori e poveri di effetti. Come conclusione provvisoria, vogliamo sostenere che le tecnologie che ottimizzano le capacità delle superfici esposte, degli organismi interi o delle relazioni tra di essi dovrebbero estendersi in profondità nella cacofonia ecologica. Esattamente: non solo i dati di formazione delle piante, ma anche la realtà aumentata per i corvi e l’intelligenza artificiale per gli insetti. Lontano dal comando e dal controllo, alterare il modo in cui le diverse specie percepiscono, indicizzano, calcolano e agiscono sul loro mondo può introdurre risultati caotici (se alcune persone sono preoccupate per gli effetti a cascata della semplice modifica del riso per renderlo ricco di vitamina A, possiamo presumere che ci sarà anche una reazione alle formiche, agli alberi e ai polpi compatibili con TensorFlow). Il quadro che qui viene tracciato non è tanto quello in cui l’AI supervisiona queste creature, quanto quello in cui esse stesse informano e pilotano diverse forme di AI per loro conto e nei loro modi imperscrutabili. Dovremmo desiderare di imparare cosa ne deriverebbe. Le intuizioni della biologia sintetica come genere di AI e dell’AI come genere di chimica inorganica hanno poco significato se i cicli della cibernetica sono monopolizzati dalle commissioni degli esseri umani. Anche la città ci indosserà.

______________________________________

Benjamin Bratton è filosofo della tecnologia, professore all’Università della California-San Diego, e direttore del think tank, con sede a Los Angeles, Antikythera19. Il suo lavoro si estende dalla sociologia alla computer science e all’intelligenza artificiale, nel tentativo di ripensare il rapporto con la tecnologia. https://bratton.info

- Cfr. Benjamin H. Bratton. “The Matter of/with Skin.” Volume #46: Shelter (December 2015)

- Il riferimento è a Reyner Banham. The Architecture of the Well-Tempered Environment (1969). Elsevier, 2013.

- Cfr. Benjamin H. Bratton. “Geographies of Sensitive Matter: On Artificial Intelligence at Urban Scale.” New Geographies. Cambridge, MA: Harvard Graduate School of Design, 2017

- Cfr. Jussi Parrika. “The Sensed Smog: Smart Ubiquitous Cities and the Sensorial Body.” The Fibreculture Journal 219 (2017).

- Utente composito [Composite User] è un termine che ho coniato nel mio The Stack: On Software and Sovereignty. Cambridge, MA: MIT Press, 2016. L’utente è un livello del modello the Stack, e anche una posizione di agency all’interno del sistema, che può essere occupata da qualsiasi attore umano o non umano in grado di interagire con il livello Interfaccia. Un Utente composito è costituito da più entità contemporaneamente che interagiscono con il sistema come se fosse una singola entità.

- Il libro di testo di riferimento per queste tecniche è stato John R. Jensen. Remote Sensing of the Environment: An Earth Resource Perspective. Pearson, 2006. Print. Jennifer Gabrys provides an alternative model in Program Earth: Environmental Sensing Technology and the Making of a Computational Planet. Minneapolis: University of Minnesota Press, 2016. Print.

- La semantica dei confini è esplorata da progettisti come Rei Kawakubo, Hussein Chalahayn, Iris van Herpen, e molti altri. Al fine di descrivere la moda come forma antecedente della biologia sintetica populista, Lucy McRae mette in gioco la predazione e l’esibizione (offensiva/difensiva, aggressiva/seduttiva) tra organismi singoli e li lascia senza risoluzione. Se da un lato questi possono far pensare a immagini biotecnologiche del sé, e solo secondariamente alle specie, dall’altro un’estetica della standardizzazione (Laibach, Wal-Mart, armadi completamente neri) descrive un corpo di massa mutevole.

- Cfr. Elizabeth Grosz. Chaos, Territory, Art: The Framing of the Earth. New York: Columbia University Press, 2008. Hanna Rose Shell. Hide and Seek: Camouflage, Photography, and the Media of Reconnaissance. Cambridge, MA: Zone Books, 2012.

- For more of McRae’s work see https://www.lucymcrae.net

- La Conferenza di Asilomar sul DNA ricombinante del 1975 ha stabilito le linee guida per gli esperimenti scientifici sull’uso di tale DNA e ha fornito, da allora, un quadro precauzionale relativo a tali ricerche. La conferenza è considerata un evento importante nella consapevolezza e nel dibattito pubblico sulla sicurezza e la correttezza della bioprogettazione avanzata. Più di recente, vertici simili hanno cercato di inquadrare lo sviluppo delle tecniche di editing genico CRISPR/Cas9, con gradi di successo variabili e incerti.

- Timothy Morton si spingerà fino a sostenere che la causalità e l’estetica sono la stessa cosa. Cfr. il suo Realist Magic: Objects, Ontology, Causality. Ann Arbor: University of Michigan, 2013. Probabilmente, questo dibattito è ritardato dall’inflazione e dall’estensione della critica letteraria o artistica alle scienze umane in generale. Come dice Peter Wolfendale, “tutto viene trattato come un simbolo e le connessioni simboliche vengono liberamente sostituite a quelle causali”. Un esempio di come questo porti a confondere il mondo con le “letture” preferite del mondo è TJ Demos. Si veda, ad esempio, come il suo incarico di critico d’arte lo conduca a stravaganti raccomandazioni sulla politica e sui programmi della biotecnologia, dell’economia ecologica, della politica agricola e delle infrastrutture di approvvigionamento alimentare intese come “opere” ai quali possiamo “rispondere”.” Per approfondimenti, fare riferimento al suo talk, “Gardens Beyond Eden Bio aesthetics Eco futurism and Dystopia at dOCUMENTA (13).” 18 June 2013. The White Building. in cui traccia una distinzione opportunamente netta tra il lavoro della già citata Shiva e quello di Donna Haraway, ma da lì si dirige verso cul-de-sac tipicamente solipsistici.

- Cfr. nanome.ai and SteamVR dove versioni funzionanti di ognuna di tali applicazioni è disponibile per il download.

- Chiaramente, l’effettiva complessità della chimica è di gran lunga maggiore rispetto a questi blocchi digitali animati, seppure il loro scopo sia quello di un’astrazione funzionale. Il punto di questo strumento di design non è quello di produrre un doppio della materia ontologicamente accurato. Piuttosto, è quello di offrire strumenti con cui progettare modelli di astrazioni efficaci come parte dei flussi di lavoro fra i banchi di laboratorio.

- Altre aziende e progetti che lavorano all’intersezione tra IA e ricerca biotecnologica includono Atomwise, Mendel.ai, GEA Enyzmes, e A2A Pharma.

- Il termine “materialismo culinario” è preso in prestito da Collapse VII: Culinary Materialism. Falmouth: Urbanomic, 2011.

- Cfr. Aylin Caliskan, Joanna J. Bryson, Arvind Narayanan. “Semantics derived automatically from language corpora contain human-like biases.” Science 356 (14 April 2017): 183-186. e Anthony G. Greenwald. “An AI stereotype catcher.” Science 356 (14 April 2017): 133-134. Print.

- Non c’è dubbio che, a un certo livello, l’”inflazione ontologica” dell’informazione nel descrivere l’universo e tutto ciò che ne fa parte è causato dal modo in cui le nostre tecnologie contemporanee ci mostrano il mondo, ma non che siano le sole

- McKenzie Wark discute di questa “frattura metabolica” in Molecular Red: Theory for the Anthropocene. Verso Press, 2015. Print.

- Il programma di Antikythera si interessa allo studio della tecnologia e del suo impatto sul mondo dalla prospettiva che Bratton chiama Planetary-Scale Computation: “Instead of applying existing philosophy to the topic of computation, Antikythera starts from the other direction, recognizing that technologies generate ideas as much as ideas generate technologies”.